Overview

본 연구의 주요 목표는 가우시안 스플래팅 기술을 LED 월 기반 가상 제작(Virtual Production) 환경에 통합하고, 이 기술의 실질적인 성능과 적용 가능성을 평가하는 데 있다. 특히, 다음과 같은 점에 중점을 두었다.

GS 기반 3D 환경 제작: LED 월에 사용할 수 있는 몰입감 있는 3D 배경 생성

기술적 문제 해결: 실시간 엔진으로 GS 데이터를 가져올 때 발생하는 데이터 손실 문제 해결

실시간 조명 및 장면 수정 실험: 조명 변경 및 장면 구성의 유연성 테스트

The primary goal of our research was to evaluate the integration of GS into virtual production workflows, particularly in the context of LED wall environments. This approach eliminates the need for extensive physical set construction, enabling more dynamic and cost-effective productions. Specifically, we aimed to:

Create realistic 3D environments using GS for LED wall projections

Address technical challenges such as data fidelity loss during Unreal Engine imports.

Experiment with real-time lighting adjustments and scene modifications

Gaussian Splatting Introduction

가우시안 스플레팅(GS)은 2023년에 발표된 혁신적인 기술로, 2D 이미지로부터 부드럽고 연속적인 3D 장면을 재구성하는 방법이다. 기존의 포토그래메트리(Photogrammetry)나 Neural Radiance Fields (NeRF)와는 달리, GS는 실시간 렌더링을 가능하게 하며, 더 적은 계산 자원으로 고품질 결과물을 제공한다. GS는 Structure from Motion(SfM) 데이터를 활용하여 포인트 클라우드를 생성한 뒤, 이를 가우시안 형태로 변환하여 렌더링한다. 가우시안은 3D 환경에서 타원체(Ellipsoid)로 표현되며, 각 점에는 크기, 색상, 투명도 등의 속성이 포함된다.

Gaussian Splatting (GS) is a cutting-edge method introduced in 2023 that reconstructs smooth and continuous 3D scenes from 2D images. Unlike traditional approaches like photogrammetry or Neural Radiance Fields (NeRF), GS provides real-time rendering capabilities with less computational demand.

By leveraging Structure from Motion (SfM) data, GS converts point clouds into Gaussian representations, which are rendered as ellipsoids with attributes such as size, color, and transparency

Research Method & Workflow

WORKFLOW

•

이미지 수집 / Image Acquisition

•

이미지 처리 / Data Processing

•

렌더링 파이프라인 / Rendering Pipeline

DJI Air 드론을 이용한 이미지 수집

Postshot을 사용한 가우시안 스플래팅 ply 파일 추출

Luma AI Plugin을 사용하여 언리얼 엔진으로 가져오기

언리얼 엔진에서 nDisplay, In-Camera VFX를 활용하여 고품질의 Virtual Production 환경을 구현

카메라 연동: Vive Mars와 LiveLink를 사용하여 버추얼 카메라와 실제 카메라를 연동

LED 월에 투사: LED 월에 프로젝션하여 Virtual Production을 구현

RESULTS

GS 기술을 사용한 LED 월 배경은 배우와 작업자에게 몰입감 있는 작업 환경을 제공

조명 변경과 공간 구성의 실시간 조정이 가능해 창의적 유연성을 확보

2D Background Compositing

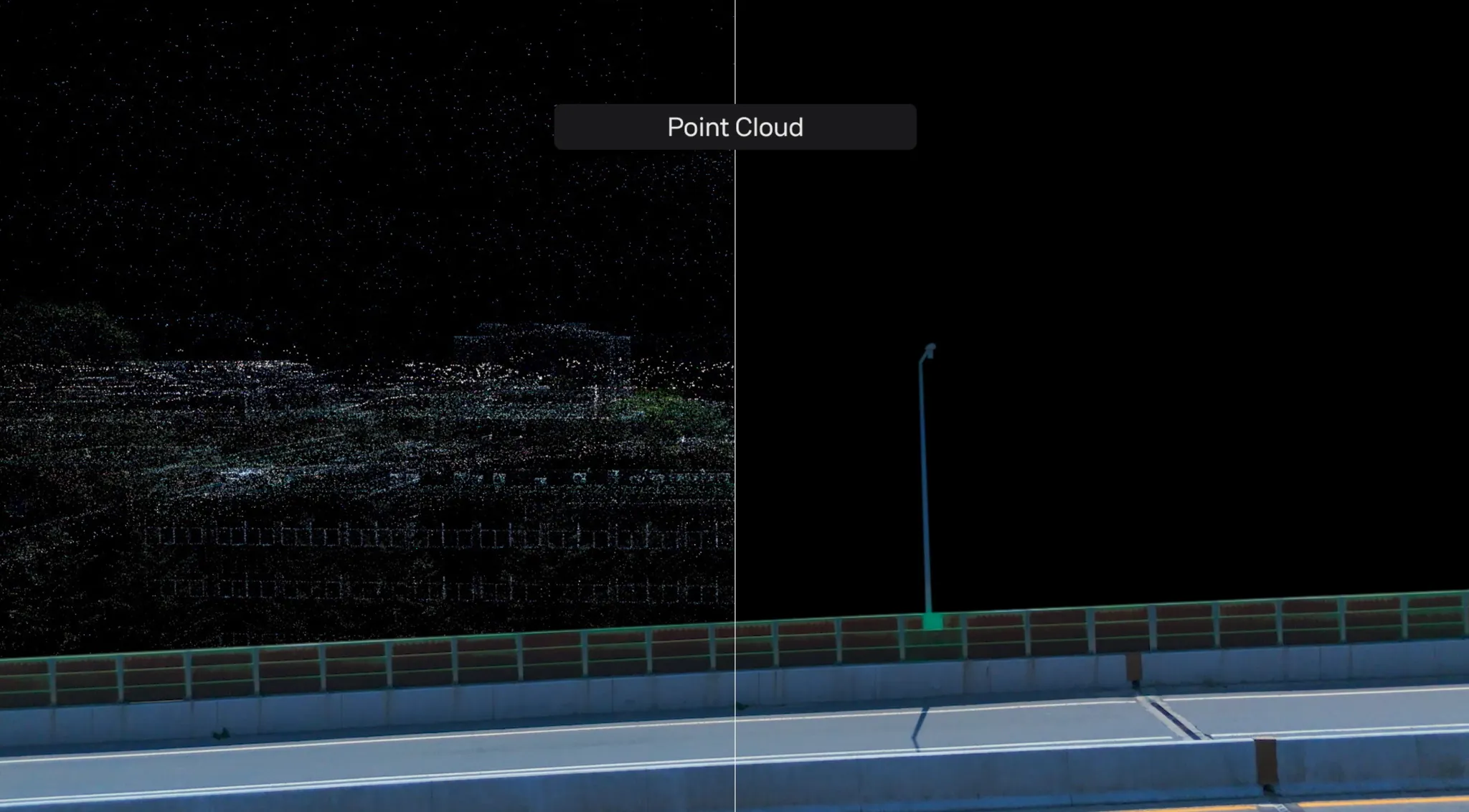

Point Cloud

PreComp

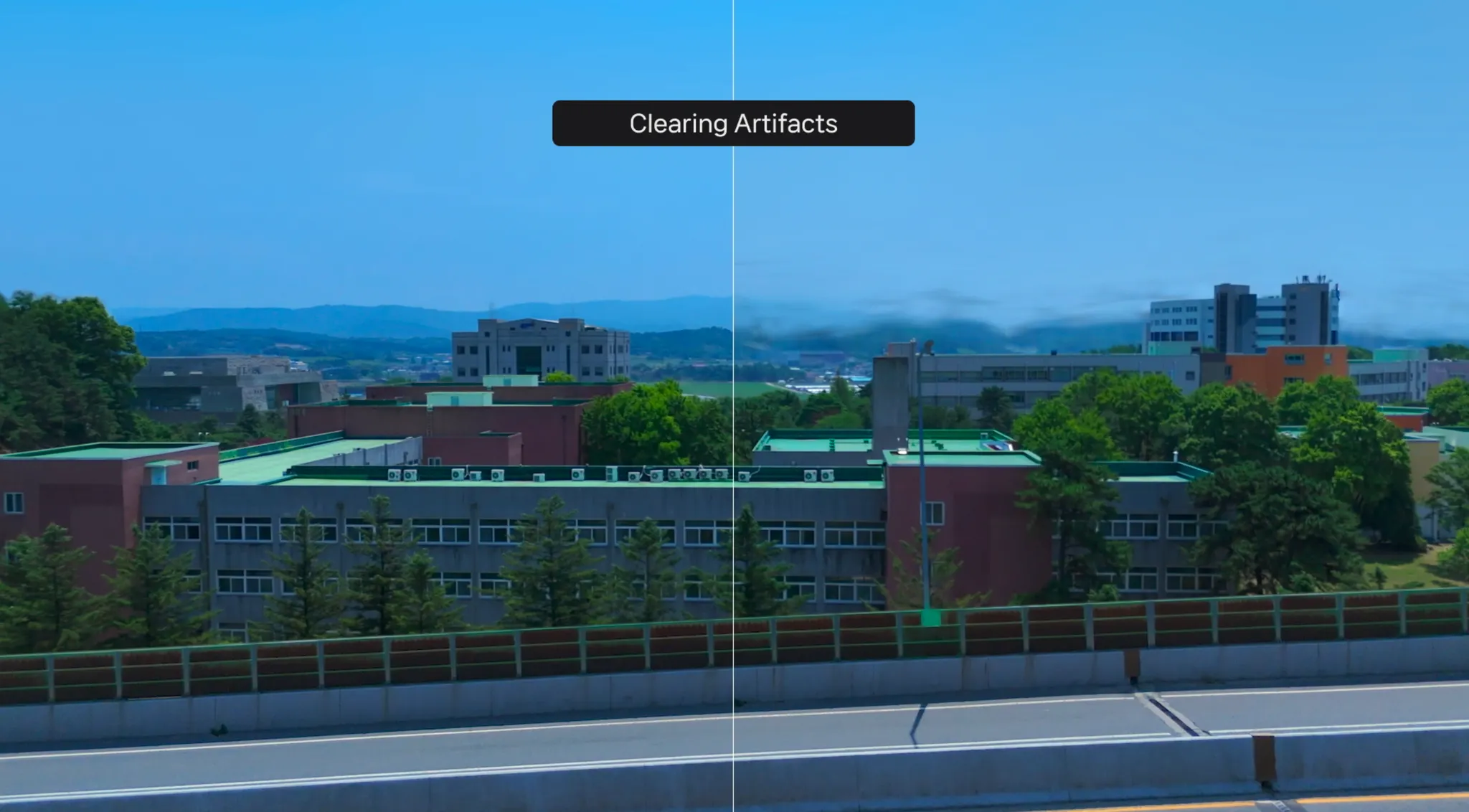

Clear Artifacts

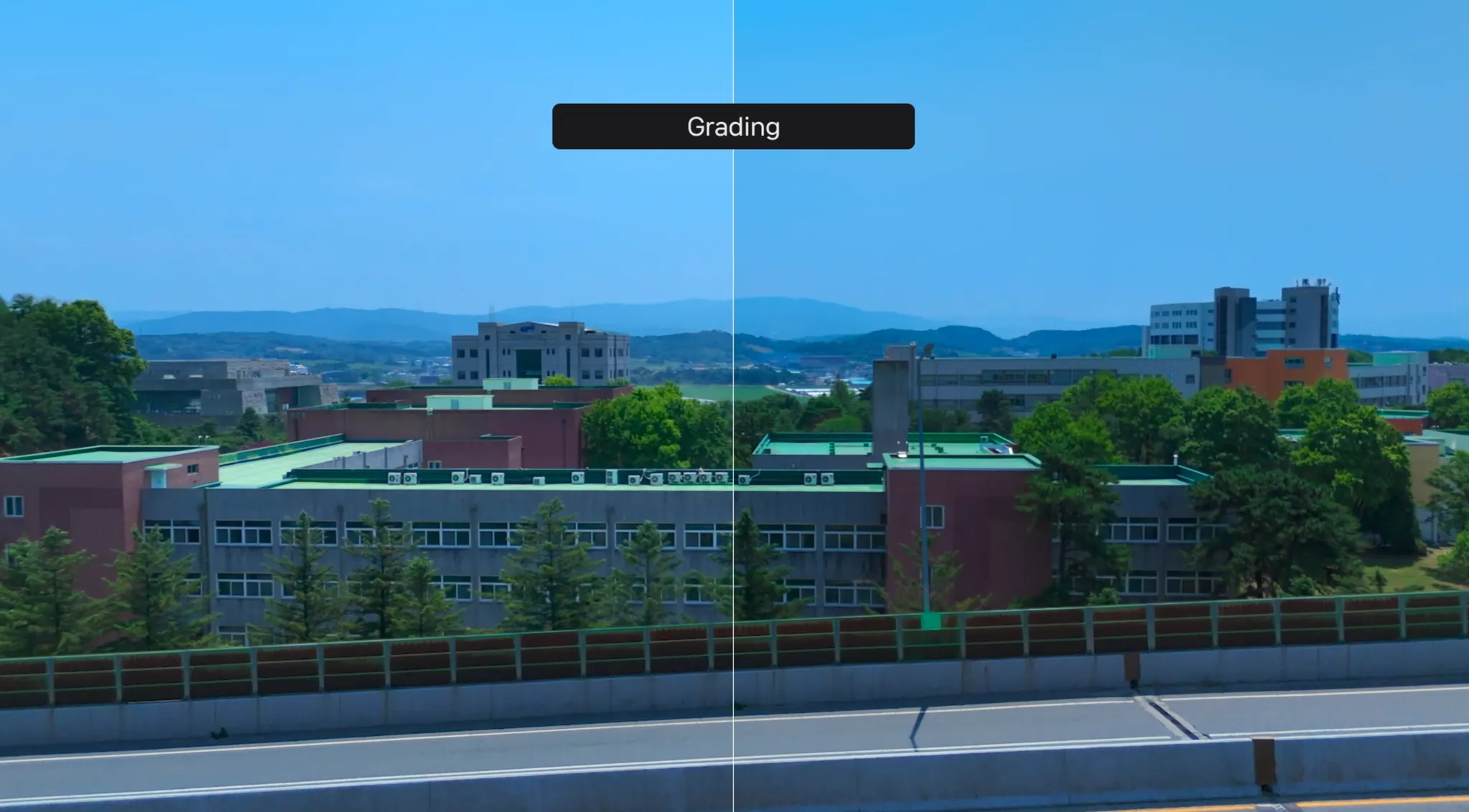

Grading

Depth

NeRF vs GS Comparison

NeRF vs. GS:는 뛰어난 렌더링 품질을 제공하지만, 실시간 처리가 불가능하며 고성능 하드웨어가 필요하다. 반면 GS는 상대적으로 적은 자원으로 실시간 렌더링을 지원하며, 가상 제작 환경에 적합한 기술로 평가되었다.

NeRF vs. GS: NeRF excels in rendering quality but lacks real-time capabilities. GS, while slightly less detailed, achieves near-instant rendering, making it ideal for interactive applications.

렌더링 품질: 실험을 통해 GS가 약간의 최적화를 통해 동적인 조명 시나리오에서 세밀한 디테일을 재현할 수 있는 능력을 보여주었다.

Rendering Quality: Experiments showed GS's capability to replicate fine details in dynamic lighting scenarios with slight optimization

Limitation

Technical Issue

데이터 손실 Unreal Engine의 Niagara 컴포넌트가 최대 200,000개의 점만 처리할 수 있어, 복잡한 장면에서 디테일이 일부 손실되었다.

모아레 현상특정 촬영 각도에서 LED 월 구조로 인해 발생하는 모아레(Moire) 패턴 문제가 확인되었다.

조명 제약현실적인 리라이팅(Re-lighting) 시스템이 부족하여 조명 조건의 섬세한 조정에 한계가 있었다.

Colmap 사용으로 인한 시간 소모 : NeRF와 GS 모두 colmap 데이터를 바탕으로 하여 colmap을 통하여 데이터를 추출하는 과정에서의 시간 손실은 동일하게 발생하였다.

Data Loss: Unreal Engine's Niagara component could only handle up to 200,000 points, leading to reduced detail in complex scenes.

Moire Patterns: Certain camera angles produced unwanted artifacts due to LED wall panel structure.

Moire Patterns: Certain camera angles produced unwanted artifacts due to LED wall panel structure.

Time Consumption Due to Colmap Usage: Both NeRF and GS rely on Colmap data, resulting in the same time loss during the data extraction process using Colmap.

Conclusion

이번 연구를 통해 가우시안 스플레팅이 가상 제작 환경에서 높은 잠재력을 지닌 기술임을 확인할 수 있었다. 실시간 렌더링 및 몰입감 있는 배경 제공 측면에서 GS는 큰 강점을 지니고 있다. 또한, NeRF와 GS 모두 colmap 데이터를 바탕으로 하여 colmap을 통하여 데이터를 추출하는 과정에서의 시간 손실은 동일하게 발생하였다. 다만, 데이터 손실 및 렌더링 제약 등 몇 가지 한계점을 보완하기 위한 추가 연구가 필요하다. 앞으로 Niagara 컴포넌트 최적화 및 리라이팅 시스템 개선에 중점을 두고 연구를 이어나갈 계획이다.

Our exploration of Gaussian Splatting for virtual production validated its potential as a transformative tool. Also, both NeRF and GS rely on Colmap data, resulting in the same time loss during the data extraction process using Colmap. While challenges like data fidelity and rendering artifacts persist, GS's real-time capabilities offer a significant advantage over traditional methods. Future work will focus on optimizing the Niagara component and developing more robust re-lighting systems.